Założyłem Flashcard Space, ponieważ nie mogłem znaleźć fiszek do nauki hiszpańskiego o wystarczająco wysokim standardzie jakości. Na pierwszy rzut oka, stworzenie fiszki wydaje się łatwym zadaniem. W rzeczywistości jednak trzeba wziąć pod uwagę wiele czynników, aby taki materiał stał się wartościową pomocą w nauce.

Zestawy fiszek, które zwykle znajduję na Quizlet lub w repozytorium Anki, często dotyka jeden lub więcej z poniższych elementów:

- literówki (trafiam na nie znacznie częściej, niż się spodziewałem)

- nieprecyzyjne tłumaczenia (bo np. “ładny” i “piękny” to dla mnie dwa różne słowa, a nie synonimy)

- brak nagrań audio lub ich niska jakość

- brak przykładów użycia słowa w kontekście

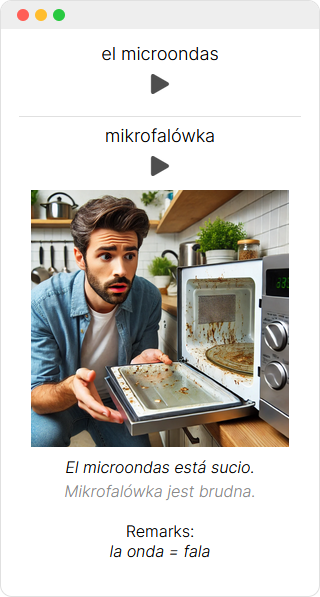

Poniżej przykład kontrastu między niedbale zaprojektowaną fiszką, typową dla Quizlet i innych zasobów tworzonych przez studentów, a bardziej dopracowaną fiszką mojego autorstwa:

Celem projektu Flashcard Space jest dostarczenie fiszek drugiego typu, żeby skuteczniej budować zasoby słownictwa.

Nasz proces kontroli jakości

Gdy piszę to w 2024 roku, coraz więcej treści w Internecie jest generowanych przez narzędzia AI, takie jak ChatGPT. Twórcy czasem idą na nieetyczne skróty i publikują treści śmieciowej jakości. Jakie my mamy podejście do użycia sztucznej inteligencji?

Z mojego doświadczenia wynika, że współczesne modele AI dobrze radzą sobie z pracą z językami i pomagają oszczędzać czas, ale jeszcze nie są na tyle precyzyjne, by zautomatyzować proces w całości i uzyskać zadowalająco niski poziom błędów.

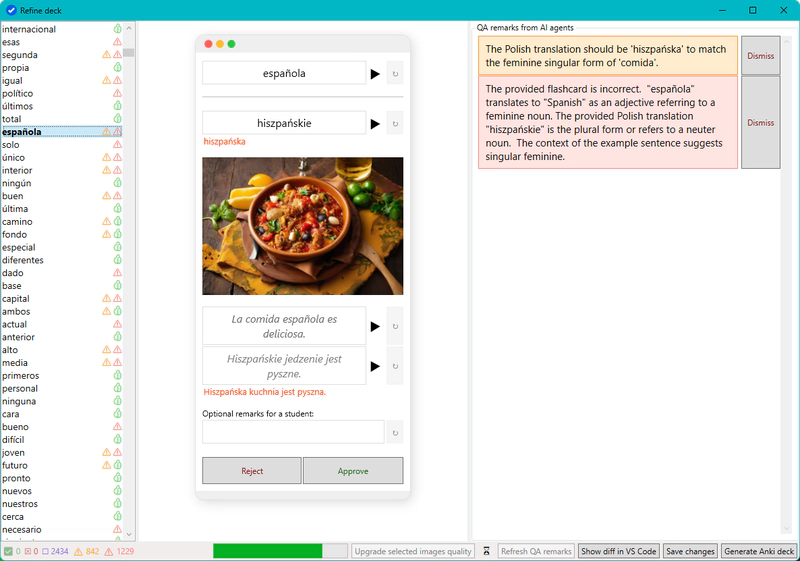

W Flashcard Space opracowaliśmy własne narzędzia, które pomagają nam tworzyć fiszki. Te narzędzia dość intensywnie wykorzystują modele AI, co znacznie zmniejsza obciążenie osób tworzących fiszki powtarzalnymi zadaniami i sprawia, że projekt jest ekonomicznie opłacalny. Jednakże kontrola jakości zawsze pozostaje w rękach człowieka: eksperta, który poprawia błędy, korzystając przy tym z alternatywnych źródeł (słowników, zasobów internetu i własnego doświadczenia z językiem).

Oto zrzut ekranu wczesnej wersji naszego narzędzia. Możesz np. zauważyć, że autor otrzymuje od programu ostrzeżenia dotyczące potencjalnych błędów w treści fiszek, co pomaga mu nie przeoczyć problemów i ręcznie skorygować treść przed jej zatwierdzeniem:

Modele AI używane w procesie

Dla przejrzystości, poniżej przedstawiam listę modeli AI obecnie wykorzystywanych w naszym procesie:

gpt-4ood OpenAI jest używany do klasyfikacji słów (na rzeczowniki, przymiotniki, czasowniki, …), do generowania przykładów zdań, oraz jako jeden z silników generujący ostrzeżenia o potencjalnych błędach.gemini-1.5-pro-002od Google jest stosowany jako alternatywny silnik wykrywania błędów. Używa innego modelu i promptu niżgpt-4o, dzięki czemu często generuje dodatkowe spostrzeżenia.claude-3-5-sonnet-20241022od Anthropic jest używany jako alternatywny silnik w weryfikacji, zwracający uwagę na kolejne możliwe problemy.stable-diffusion-xl-base-1.0jest używany do generowania zestawu potencjalnych ilustracji dla każdej fiszki. Ostatecznie ilustracja jest jednak wybierana przez człowieka (lub wszystkie są odrzucane).flux.1-devjest używany do gnerowania ilustracji w naszych nowszych kursach.

Zazwyczaj korzystamy z najnowszych modeli w ich najbardziej zaawansowanych wersjach. Wyjątkiem jest model generującego obrazy, w którym wybraliśmy bardziej konserwatywne podejście i starszy model, aby uniknąć problemów licencyjnych.